이번 포스트에서는 AutoGen Studio의 플레이그라운드를 통해 Ollama의 Mistral 모델을 활용하는 과정을 단계별로 소개합니다. 로컬LLM과 AI 기술의 결합을 통해 얻을 수 있는 이점을 집중적으로 탐구하며 Ollama와 AutoGen Studio를 통해 로컬에서 AI 에이전트를 운영하는 실제 사례를 제공합니다.

Ollama와 AutoGen Studio 설치가 선행되어야 합니다. 이에 대한 상세한 가이드는 Ollama #1: 비용 걱정 없이 내 컴퓨터에서 제약 없는 LLM 실행하기와 AutoGen Studio #1: 직관적인 다중 AI 에이전트 워크플로우 구성 및 관리에서 찾아볼 수 있습니다.

Ollama에 Mistral 모델 설치

Ollama를 활용하여 로컬 LLM 환경에서 Mistral 모델을 설치해야 합니다. 이 과정은 사용자가 로컬에서 직접 AI 모델을 테스트하고 실험할 수 있는 기반을 마련합니다.

ollama run mistral

LiteLLM (현재 이 과정은 필요 없습니다)

LiteLLM은 다양한 LLM API를 OpenAI 형식으로 호출할 수 있도록 해주는 도구입니다. 이는 Bedrock, Azure, OpenAI, Cohere, Anthropic, Ollama, Sagemaker, HuggingFace, Replicate 등 다양한 LLM 서비스에 대한 접근성을 제공합니다. 자세한 내용은 LiteLLM의 공식 GitHub – BerriAI/litellm 페이지에서 확인할 수 있습니다.

설치

최신버전을 설치하는 것이 일반적이나 2024년 3월 22일 기준 최신 버전에 문제가 있어 1.32.1 버전을 설치하도록 하겠습니다.

pip install litellm==1.32.1

1.32.1 버전을 설치한 후 실행 시 에러가 발생하면 다음 명령을 추가로 실행합니다.

pip install 'litellm[proxy]'

Mistral 모델 실행

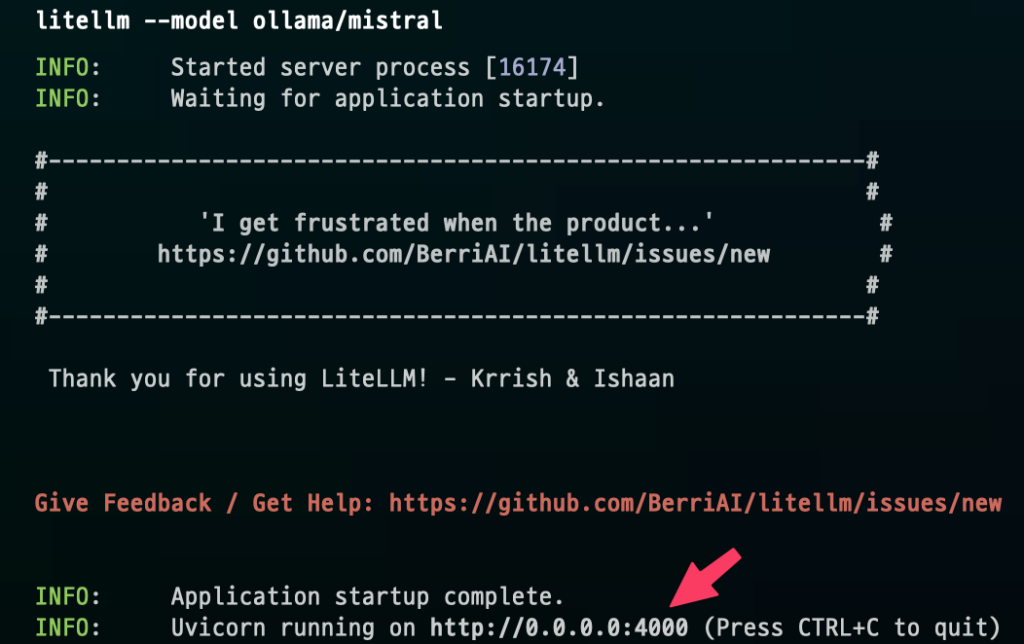

LiteLLM을 통해 Mistral 모델을 실행하는 명령어는 사용자가 OpenAI 형식으로 API를 호출할 수 있도록 지원합니다.

litellm --model ollama/mistral

실행에 문제가 없을 경우 다음과 같은 화면을 보실 수 있습니다. 주소값은 나중에 필요하므로 확인해야 합니다.

AutoGen Studio

Mistral 모델이 준비되면 AutoGen Studio를 통해 AI 에이전트를 생성하고 테스트하는 과정을 진행합니다. 이 단계는 다중 AI 에이전트를 활용하는 실질적인 예를 제공합니다.

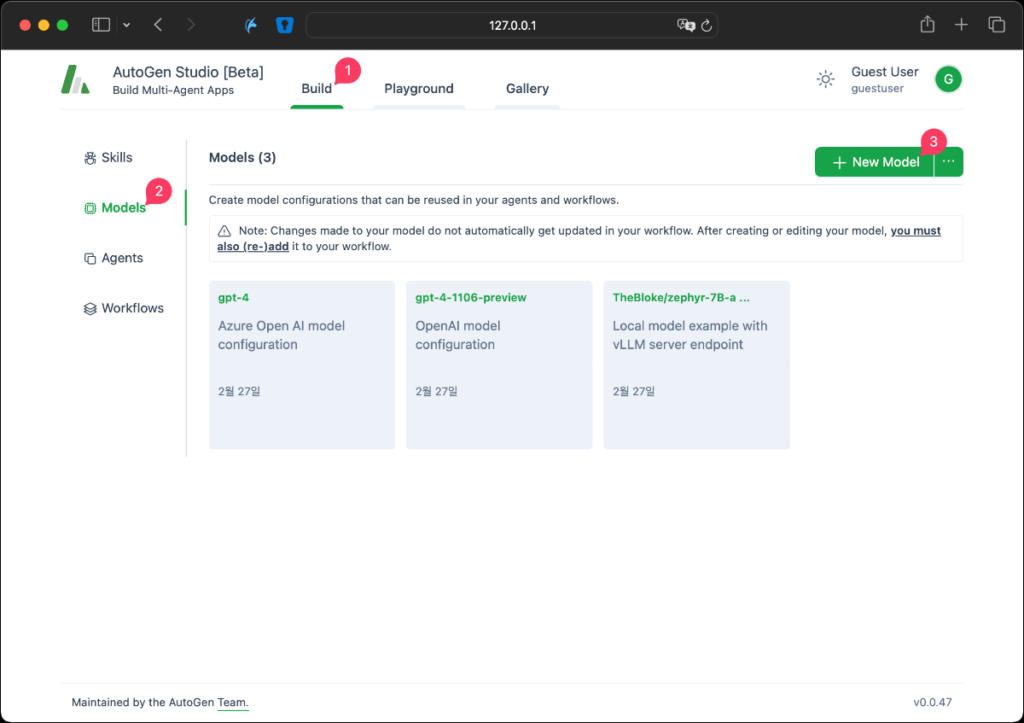

Model 생성

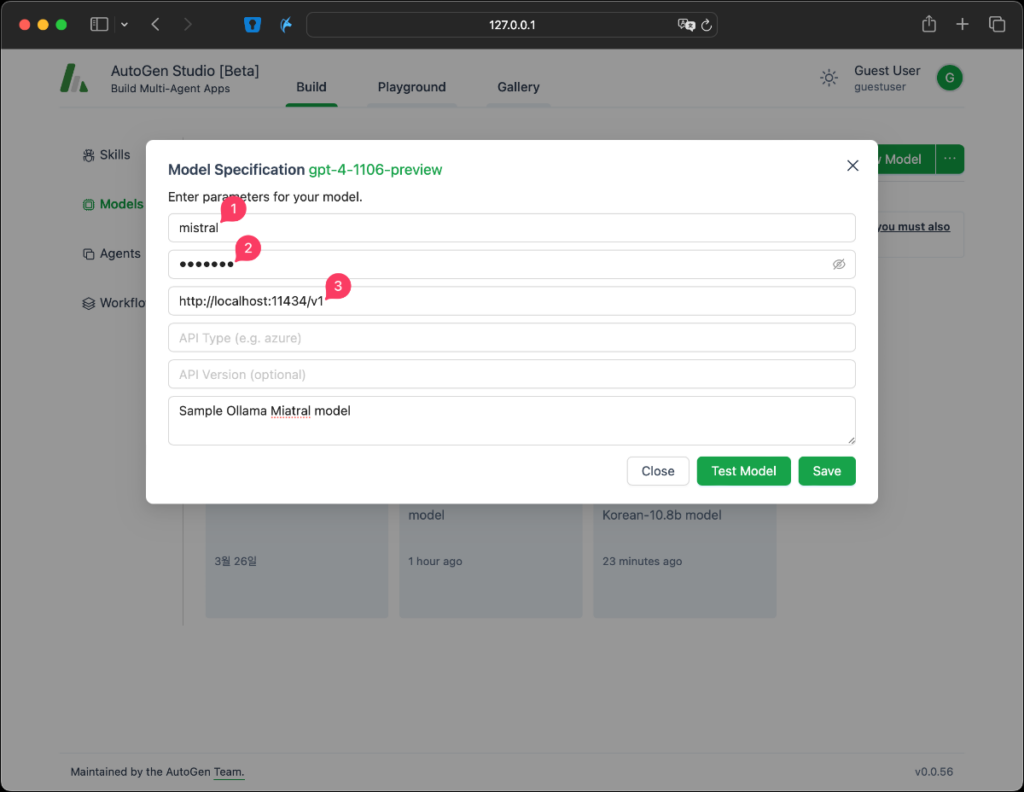

Build > Models 탭에서 New Model을 선택합니다.

Model Name에는 원하는 이름을 넣으시면 됩니다. ‘mistral’을 입력합니다.API Key는 임의의 어떤 값이던 채워 넣기만 하면 됩니다. mistral을 입력했습니다.Base URL에는 앞서 LiteLLM을 실행시키고 확인했었던 주소를 넣어줍니다. 저는 http://0.0.0.0:4000이었습니다.

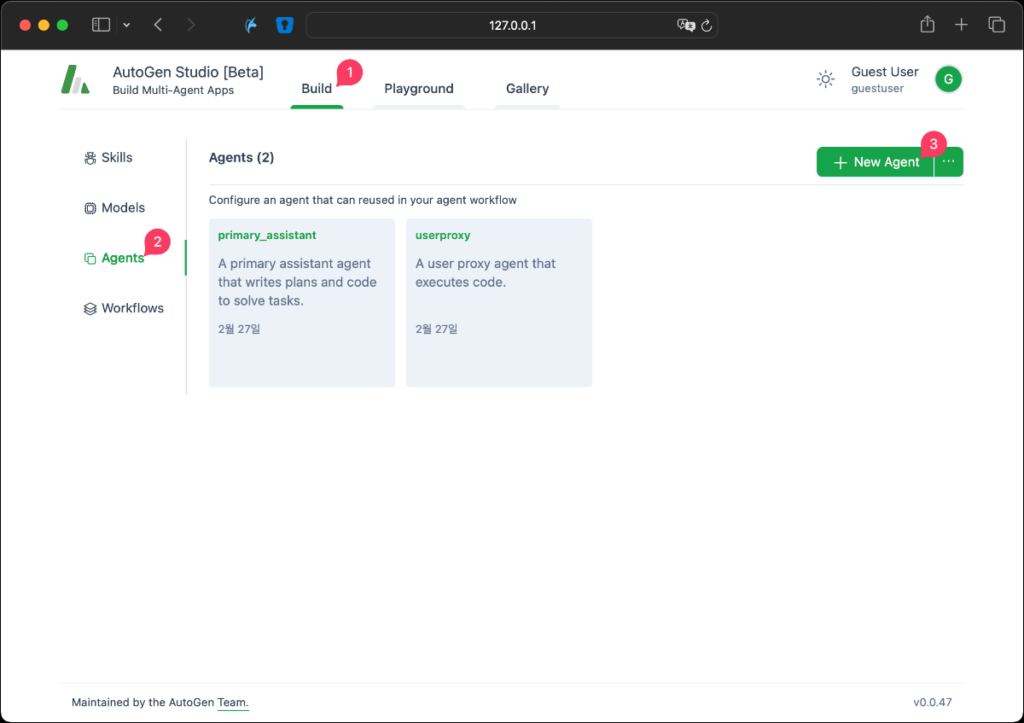

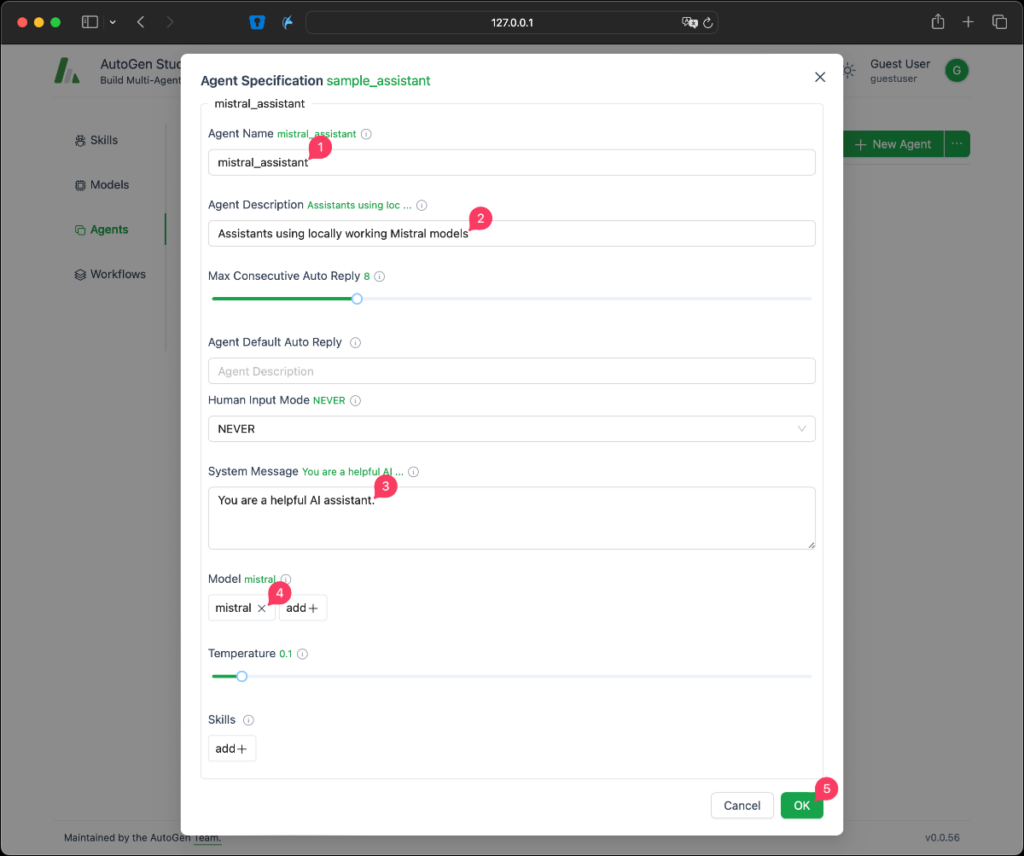

Agent 생성

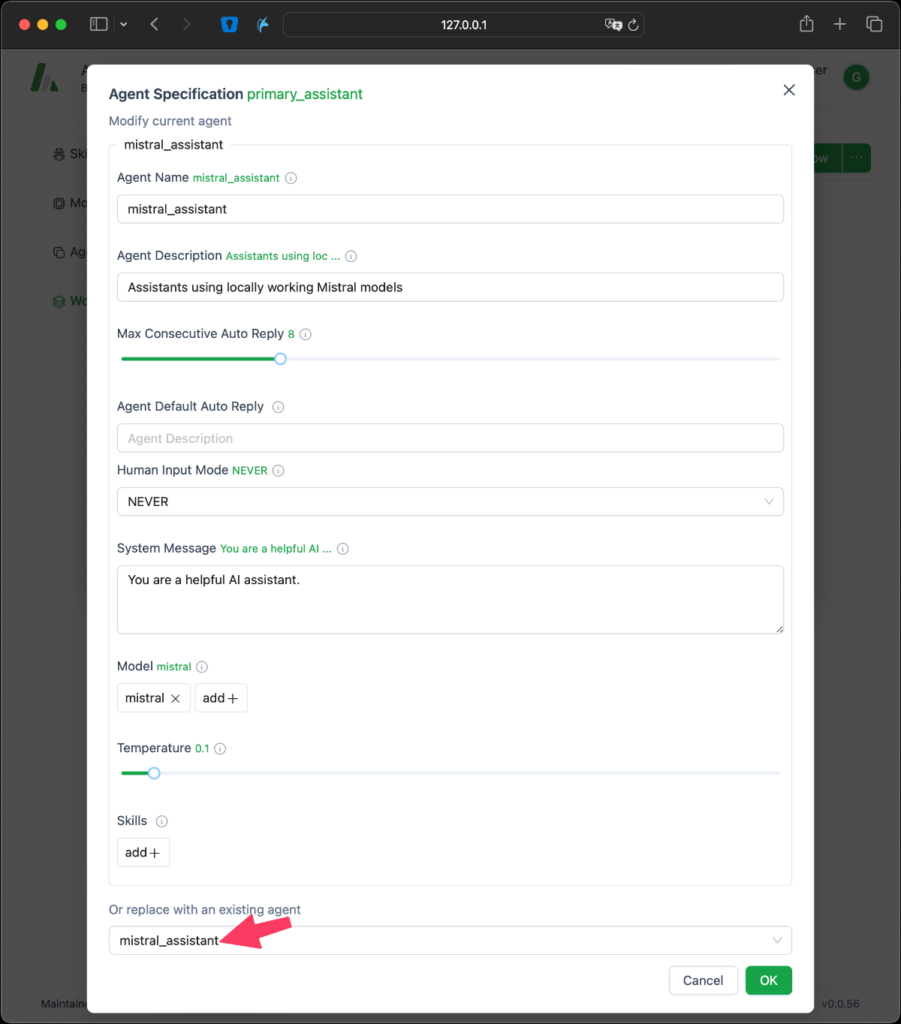

Build > Agents 탭에서 New Agent버튼을 선택해 Agent를 생성합니다.

Agent Name 은 원하는 이름을 입력합니다. 저는 ‘mistral_assistant’로 설정했습니다.Agent Description에는 간단한 설명을 입력합니다. ‘Assistants using locally working Mistral models’System Message에는 ‘You are helpful assistant’라고 간단하게 입력합니다.Model은 기본 설정된 모델을 삭제하고 우리가 만든 Mistral 모델을 추가합니다.

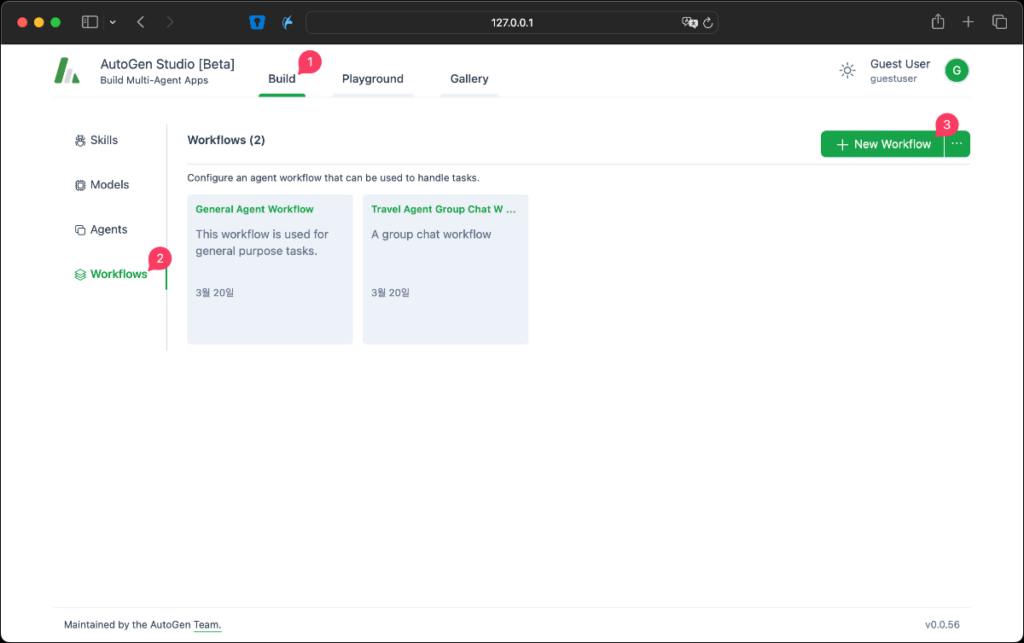

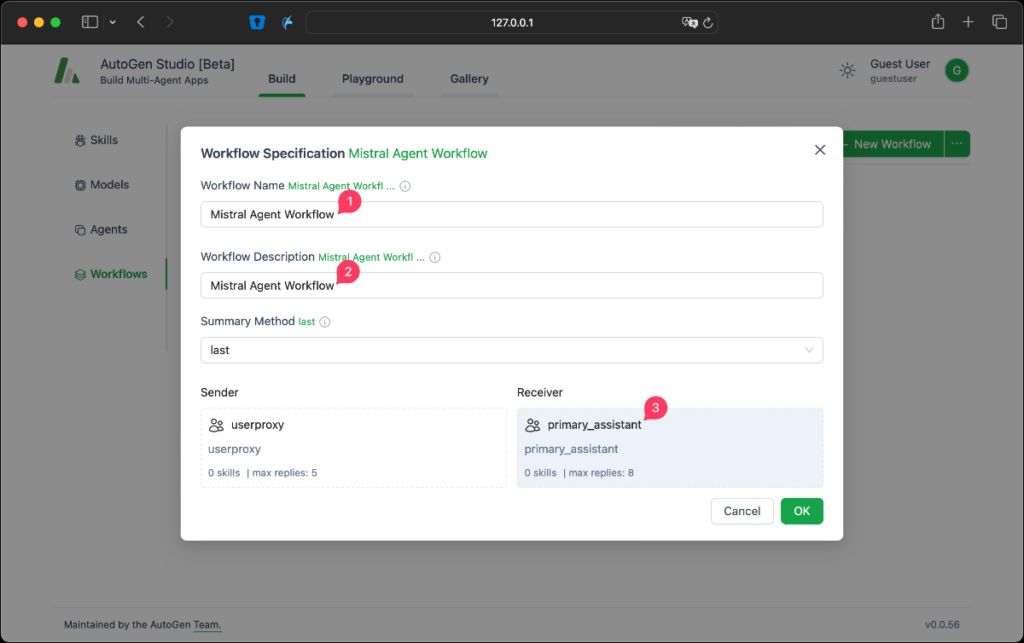

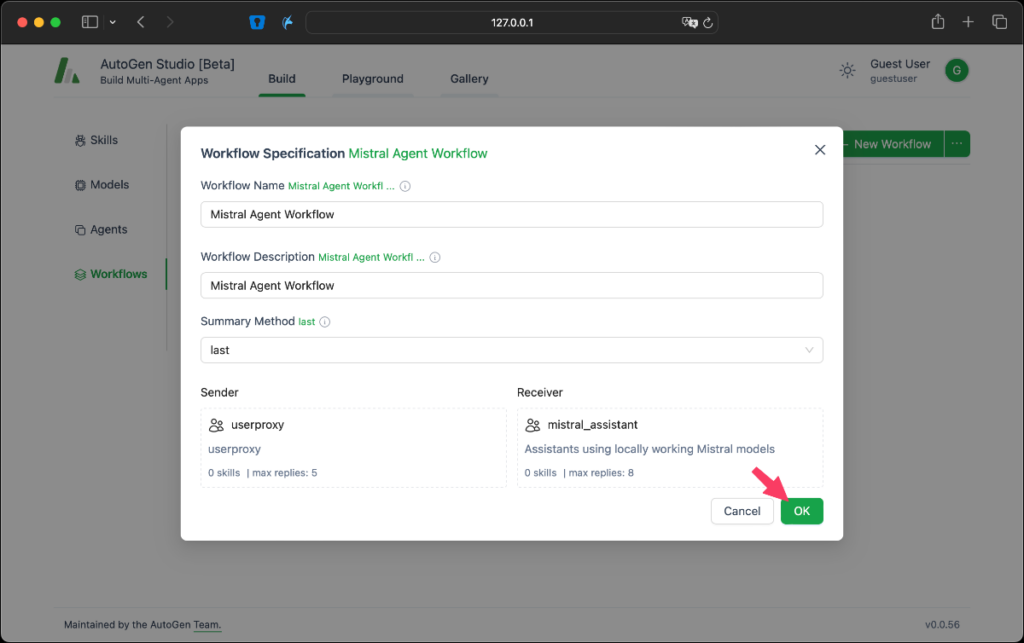

Workflow 생성

이 단계는 AI 에이전트의 작동 프로세스를 정의하고, 로컬LLM을 활용한 다중 AI 에이전트 시스템에서의 상호작용 방식을 설정합니다.

Build > Workflows 탭을 선택하고 New Workflow버튼을 눌러 새 Workflow를 생성합니다.

Workflow Name는 ‘Mistral Agent Workflow’로 설정합니다.Workflow Description도 동일하게 ‘Mistral Agent Workflow’라고 입력합니다.Receiver인 primary_assistant를 선택합니다.

사용할 Agent를 설정해야 합니다. 기존에 mistral_assistant를 생성했기 때문에 Agent Specification의 각 항목을 입력하는 것이 아니라 하단에 있는 Or replace with an Existing agent에 선택할 수 있는 UI가 있습니다. 여기서 mistral_agent를 선택하면 자동으로 설정됩니다. 만약 선택해도 반응이 없다면 다른 항목을 한번 선택한 다음에 다시 mistral_agent를 선택해 보시기 바랍니다.

설정이 완료되면 OK 버튼을 선택합니다.

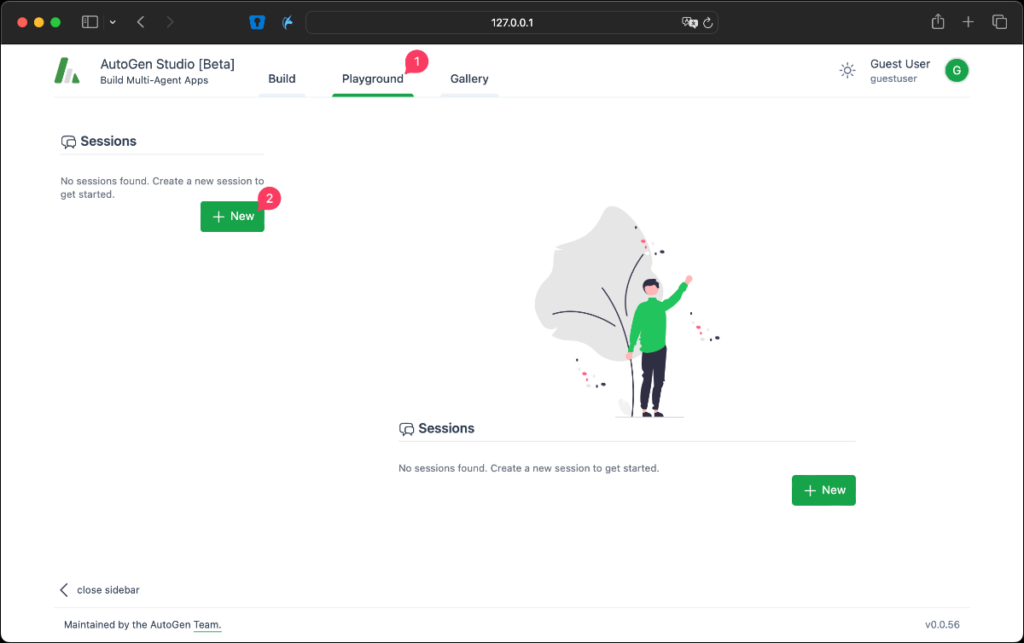

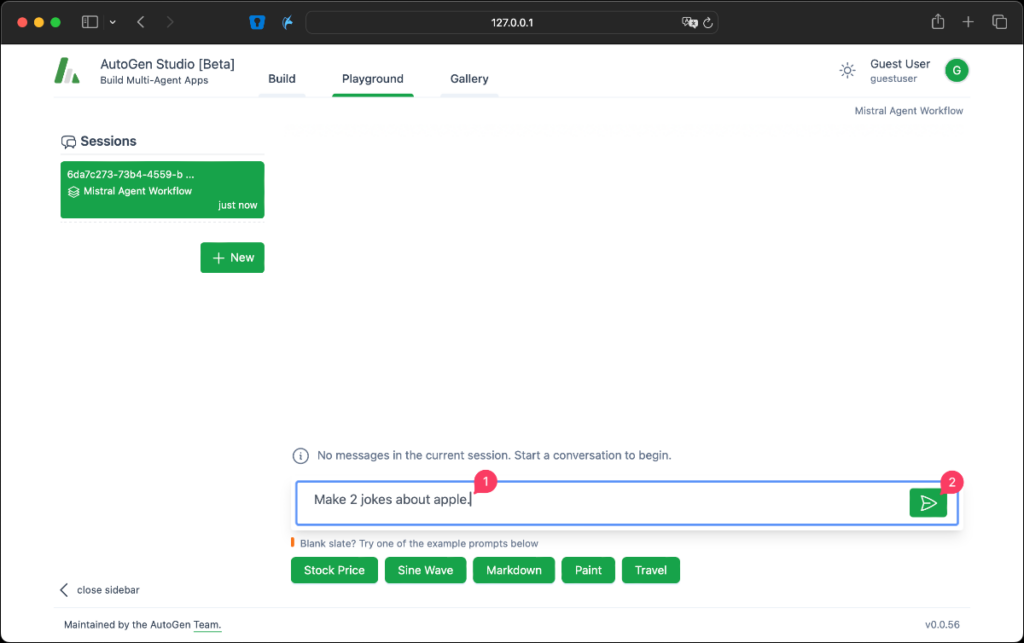

Playground에서 테스트

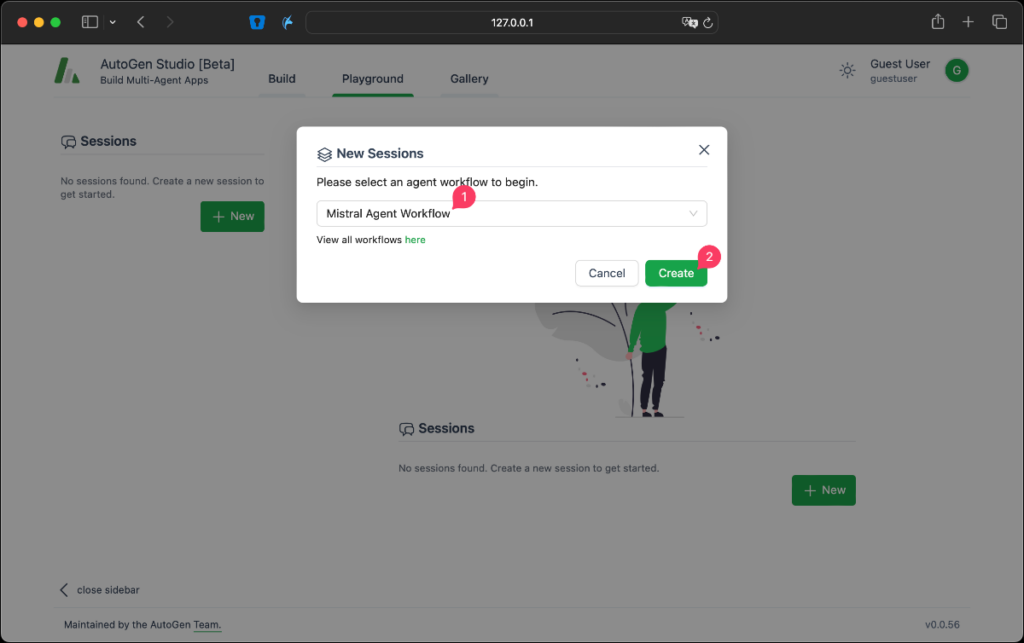

Playground는 실제 사용 사례를 시뮬레이션하고, 생성한 모델과 에이전트가 예상대로 작동하는지 확인하는 공간입니다. 여기서는 새로운 세션을 생성하고, Mistral Agent Workflow를 통해 다양한 요청을 시험해 볼 수 있습니다. 이는 사용자가 로컬LLM을 활용하여 AI 기술을 실제 환경에서 테스트하고 평가할 수 있는 기회를 제공합니다.

Playground 탭에서 Sessions 쪽 New 버튼을 눌러 새로운 Session을 생성합니다.

앞서 생성한 Mistral Agent Workflow를 선택하고 Create 버튼을 클릭합니다.

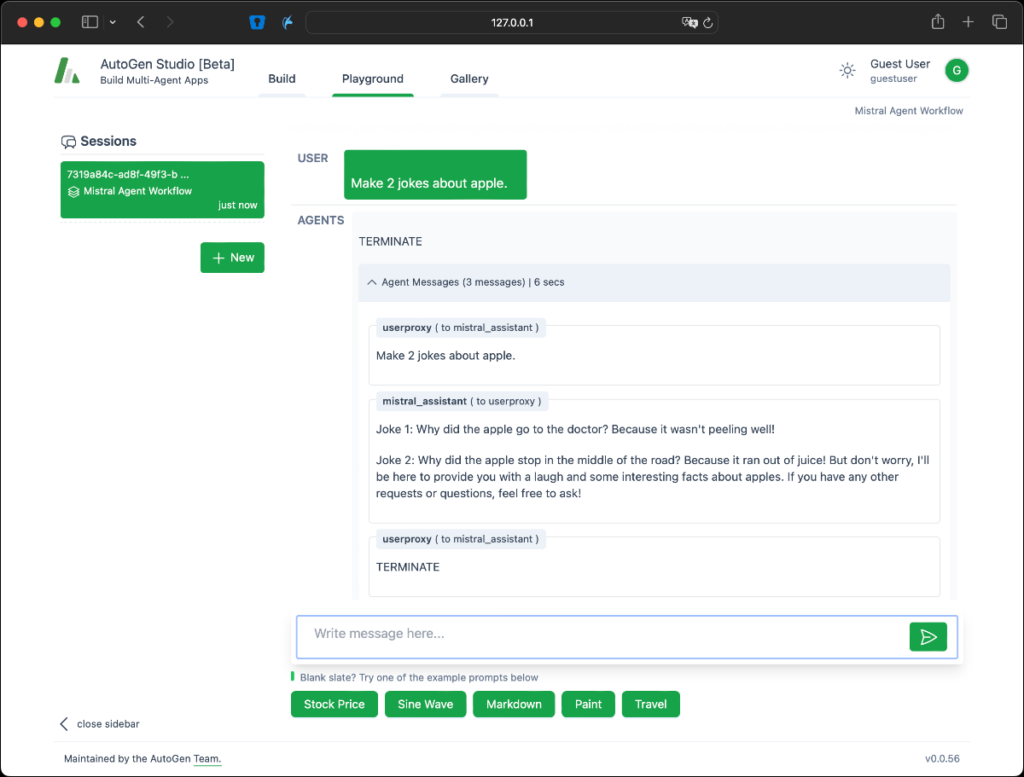

간단하게 사과에 대한 농담 2개를 만들어 달라고 요청해 봅니다.

사용자가 요청을 하면 userproxy가 mistral_assistant에 전달하고 처리가 완료되면 알아서 종료합니다.

마무리

이 글에서는 Ollama와 AutoGen Studio를 사용하여 로컬LLM 환경에서 Mistral 모델을 설치하고 다중 AI 에이전트를 활용하는 방법을 자세하게 소개했습니다.

AutoGen Studio의 사용은 개발 과정을 자동화하고, 다양한 AI 에이전트를 효율적으로 관리할 수 있게 해줍니다. 사용자 친화적인 인터페이스를 통해 복잡한 코드 없이도 AI 모델을 손쉽게 구축하고 실험할 수 있으며, 이는 AI 기술의 접근성을 크게 향상시킵니다. 또한 로컬LLM을 사용하게 되면 API 사용비용이 발생하지 않고 데이터가 로컬에서 처리되므로 외부로 유출되지 않으므로 비용절감과 보안이라는 두 가지 주요 이점을 제공하며 사용자가 다양한 LLM 모델을 자유롭게 실험하고, 프로젝트에 가장 적합한 모델을 선택할 수 있는 유연성을 제공합니다. 이러한 접근 방식은 AI 기술의 접근성을 높이고, 개인 및 기업 사용자가 보다 효율적으로 AI 솔루션을 구현할 수 있도록 지원합니다.

앞으로 지속적으로 다양한 로컬LLM의 새로운 활용 사례들을 탐색하고 다양한 활용방법에 대해 연구해 볼 예정입니다.

본 글은 GPTers에 게시되고 있습니다.

Ollama #4: AutoGen Studio 를 활용한 로컬LLM + 다중 AI 에이전트 사용 | 지피터스 GPTers